Lonjakan aktivitas AI Bot dapat membebani server dan mengganggu SEO. Ketahui cara mendeteksi trafik mencurigakan melalui logfile dan terapkan strategi seperti robots.txt untuk menjaga kinerja website tetap stabil.

Kemajuan teknologi kecerdasan buatan (Artificial Intelligence/AI) telah mendorong lahirnya berbagai bentuk bot dan agent otomatis yang aktif melakukan crawling data. Bot mesin pencari hingga AI Agent, kini semakin canggih dalam mengumpulkan informasi, menjadikan aktivitas bot sebagai elemen penting dalam ekosistem digital modern.

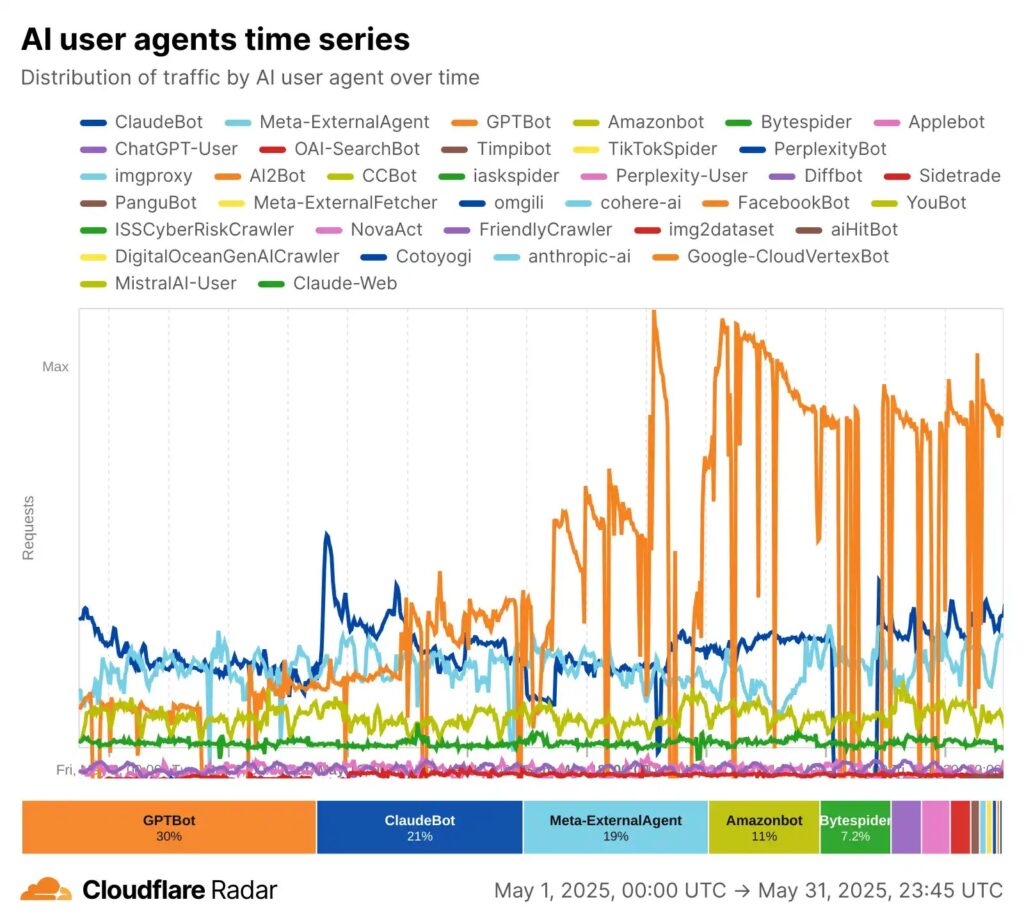

Menurut data dari Cloudflare Radar, 30% lalu lintas website berasal dari bot, dan bahkan melebihi lalu lintas internet manusia di beberapa lokasi. Namun, di balik kemudahan dan efisiensi yang ditawarkan, muncul tantangan baru bagi pemilik dan pengelola website yaitu peningkatan beban server akibat aktivitas bot yang terus berkembang.

Fenomena ini tidak hanya berpengaruh terhadap kecepatan akses, tetapi juga berdampak langsung pada konektivitas server, biaya operasional, dan bahkan peringkat SEO. Artikel ini mengulas lebih jauh bagaimana aktivitas AI Bot dapat menjadi beban tersembunyi bagi server, peran logfile untuk melakukan deteksi dini, serta langkah preventif yang dapat diambil untuk menjaga performa website tetap optimal.

Beberapa waktu ini muncul salah satu indikator yang menandakan bahwa server website Anda tengah menghadapi tekanan, salah satu nya peringatan “High Fail Rate” di Google Search Console. Ini menunjukkan bahwa Googlebot sebagai crawler mesin pencari mengalami kesulitan saat mencoba mengakses halaman situs Anda.

Menariknya, terkadang hasil pengecekan melalui cPanel atau alat pemantauan lainnya kerap menunjukkan bahwa kinerja server tampak normal. Artinya, sumber masalah belum tentu berasal dari sisi infrastruktur hosting, melainkan bisa saja disebabkan oleh lonjakan trafik eksternal, salah satunya dari bot yang tidak dikenal.

AI Bot

AI Bot adalah sebuah program kecerdasan buatan yang berfungsi untuk menjalankan tugas-tugas secara otomatis di dunia digital. Di era maraknya kemunculkan tools AI saat ini, berbagai AI Bot beroperasi dengan tujuan tertentu mulai dari mengumpulkan data, crawling, scraping, menganalisis konten dan pola pengguna atau sekadar mengindeks konten. Namun, ketika aktivitas mereka tidak dikontrol, jumlah permintaan (request) ke server bisa melonjak tajam.

Beberapa pola umum yang dilakukan oleh AI Bot agresif:

- Menjelajahi seluruh halaman situs secara berurutan tanpa jeda

- Mengakses link yang tidak ditujukan untuk publik

- Menyebabkan lonjakan trafik yang membebani server secara signifikan

Data dari Cloudflare Radar pada Mei 2025 menunjukkan bahwa GPTBot mendominasi trafik AI hingga (30%), diikuti ClaudeBot (21%) dan Meta-ExternalAgent (19%). Lonjakan aktivitas bot berpotensi membebani server. Sehingga Pengelola situs disarankan memantau logfile dan membatasi bot lewat robots.txt, firewall, atau IP block untuk menjaga performa website.

Logfile: Menyelidiki Sumber Trafik dengan Alat Sederhana

Logfile Adalah sebuah pintu pertama yang dapat digunakan untuk melihat berbagai jejak aktivitas yang tercatat oleh server termasuk aktivitas AI Bot. Terdapat berbagai cara yang dapat dilakukan untuk melihat Logfile AI Bot dari Server Website, Firewall, CDN, Aplikasi, Website, maupun Tools Analitik. Logfile umumnya akan merekam semua aktivitas mencakup

- Waktu akses

- Alamat IP (IP Address yang sama dan sering muncul berulang)

- User Agent (nama user agent atau bot)

- Halaman yang diakses

- Respons server

- Jenis permintaan yang dilakukan ke server

Logfile server dapat menjadi alat yang bermanfaat dan mudah untuk melihat berbagai aktivitas ini. Dan Anda sudah bisa mendapatkan banyak informasi penting.

Melalui informasi ini, Anda bisa menentukan bot mana yang bersifat agresif atau tidak relevan, untuk kemudian dilakukan pembatasan akses secara selektif.

Dampak Langsung pada SEO dan Biaya Server

Meningkatnya trafik dari AI bot bukan sekadar soal teknis. Jika dibiarkan, ada dua konsekuensi besar yang harus dihadapi:

Penurunan Peringkat SEO

Bot seperti Googlebot bisa mengalami gangguan saat mengindeks halaman, terutama jika server sudah terlalu sibuk menangani permintaan dari bot lain. Ini dapat menurunkan kecepatan akses dan crawlability, dua faktor penting dalam algoritma penilaian mesin pencari.

Kenaikan Biaya Operasional

Selain menurunnya peringkat SEO, aktivitas AI Bot juga menyebabkan server bekerja terlalu keras, sehingga memerlukan cost tambahan untuk melakukan penambahan bandwidth, upgrade spesifikasi CPU dan RAM dan biaya hosting yang lebih mahal. Jadi jika jumlah AI Bot tak terkendali, maka biaya untuk menjaga performa situs pun ikut meningkat.

Robots.txt: Solusi Awal bagi Bot yang Tidak Dikehendaki

Untuk membatasi aktivitas bot, Anda dapat memanfaatkan file robots.txt yang ditempatkan di direktori root situs web. File ini berfungsi sebagai panduan bagi bot mengenai bagian mana dari website yang diizinkan atau dilarang untuk diakses.

Contoh konfigurasi:

User-agent: AliyunSecBot

Disallow: /

Fungsi utama dari langkah ini yaitu

- Mengarahkan bot yang patuh agar tidak mengakses halaman tertentu

- Memberikan ruang bagi bot yang sah (misal Googlebot) untuk bekerja lebih efisien

- Mengurangi beban server secara langsung

Namun, penting diingat bahwa tidak semua bot mengikuti aturan robots.txt. Untuk bot yang tetap membandel, dibutuhkan langkah tambahan seperti firewall atau pemblokiran IP.

Evaluasi Logfile: Langkah Preventif yang Sering Terlupakan

Masih banyak pemilik website yang belum menjadikan analisis logfile sebagai bagian dari rutinitas optimasi situs. Padahal, langkah ini sangat penting tidak hanya untuk keamanan, tetapi juga dalam memahami pola akses dan potensi ancaman dari bot.

- Manfaat evaluasi logfile secara berkala:

- Mengidentifikasi trafik abnormal

- Mendeteksi keberadaan bot baru atau mencurigakan

- Mengetahui waktu-waktu dengan lonjakan trafik tertinggi

Semakin rutin dilakukan, semakin cepat pula potensi masalah dapat dicegah sebelum berdampak besar pada performa website.

Checklist Antisipasi Aktivitas AI Bot

Periksa Google Search Console secara berkala untuk mendeteksi error

- Analisis logfile minimal sebulan sekali untuk identifikasi bot mencurigakan

- Tentukan dan blokir user-agent yang tidak penting atau berbahaya

- Atur robots.txt secara strategis

- Evaluasi kapasitas server secara berkala dan diskusikan upgrade jika perlu

Semoga artikel ini menjadi pengingat bahwa optimasi website bukan hanya soal desain dan konten, tapi juga soal daya tahan di tengah arus trafik yang makin kompleks.

Kesimpulan

Dalam dunia digital yang semakin dipenuhi oleh aktivitas otomatis dan AI Bot, pengelola website dituntut untuk lebih proaktif dalam menjaga performa dan keamanan situs. Lonjakan trafik dari bot memang tidak selalu berbahaya, namun jika tidak dikontrol, ia dapat menjadi beban tersembunyi yang memperlambat server dan menurunkan kualitas SEO.

Dengan strategi sederhana seperti analisis logfile, pengaturan robots.txt, dan pemantauan rutin melalui tools seperti Google Search Console, Anda sudah berada di jalur yang tepat untuk memastikan website tetap tangguh menghadapi tantangan era AI.

Referensi

https://blog.cloudflare.com/from-googlebot-to-gptbot-whos-crawling-your-site-in-2025